2022年2月24日に新しいAOSのSTSバージョンであるAOS 6.1がリリースされました。今回は新機能の1つとして、PrismからのNutanixクラスターの複数ノードの同時削除を試してみました。

これまでは1ノード削除し、データ冗長性の回復を待ってから、次のノードの削除を操作するという流れでしたが、この機能追加によって最大4ノードまで同時に削除することができるようになりました。

具体的には、クラスターから削除する複数のノードに連続で削除対象としてマークを付ける(Remove Hostする)ことで、あとはデータの冗長性を保ちながら1ノードずつ順番に自動で切り離してくれるといった動きをするものとなります。

目次

1. 今回の環境

Platform: NX-1465-G5 + NX-1165-G4(5ノードから2ノード削除)

AOS: 6.1 STS

AHV: 20201105.30142

2. 複数ノードの同時削除

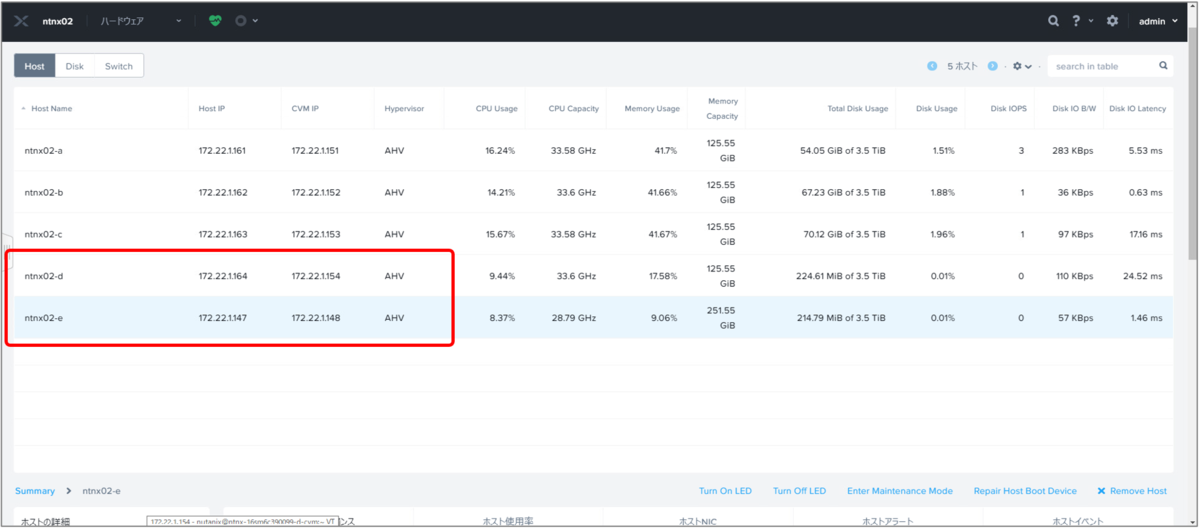

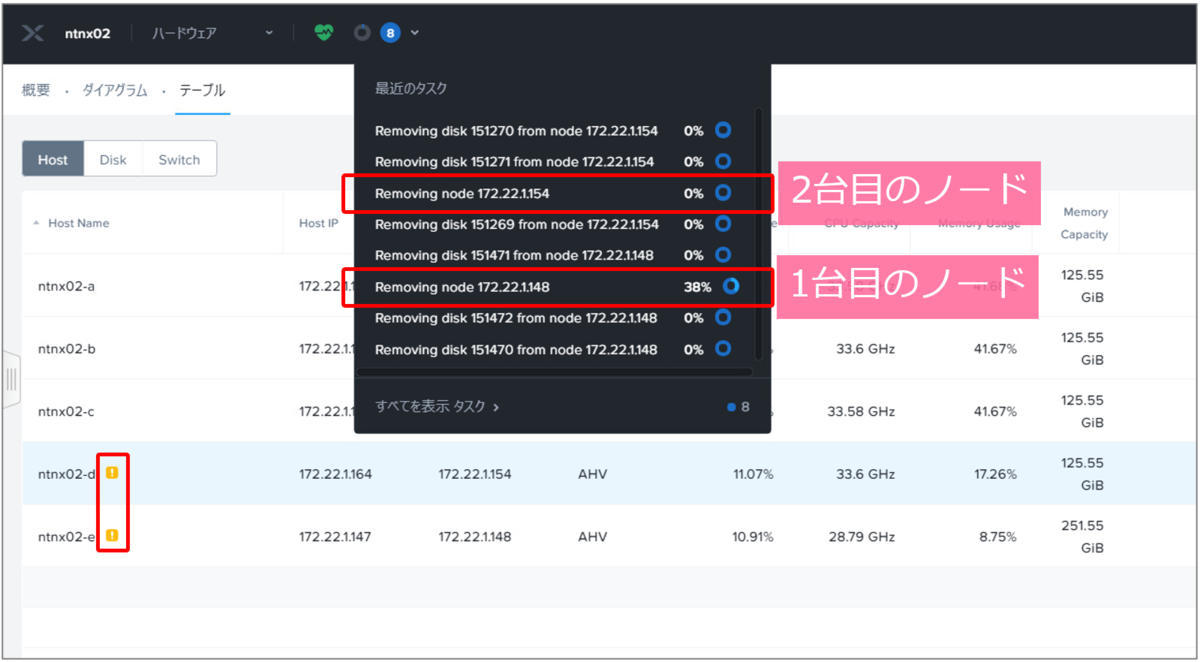

はじめにPrism Elementから、「ハードウェア」→「テーブル」→「Host」タブへ移動します。今回は、5ノード1クラスター構成で以下図の2ノードを同時に削除してみます。

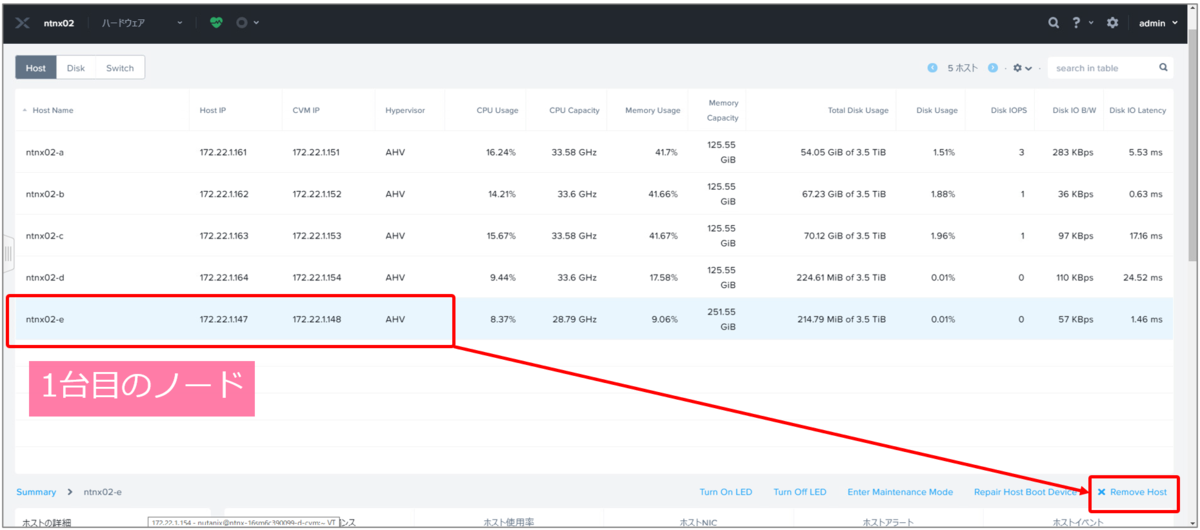

1台目のノードを選択し「Remove Host」をクリックします。

確認のダイアログで「削除」をクリックすると、削除対象としてマークされます。その後、対象ノードは自動でクラスターから削除されます。

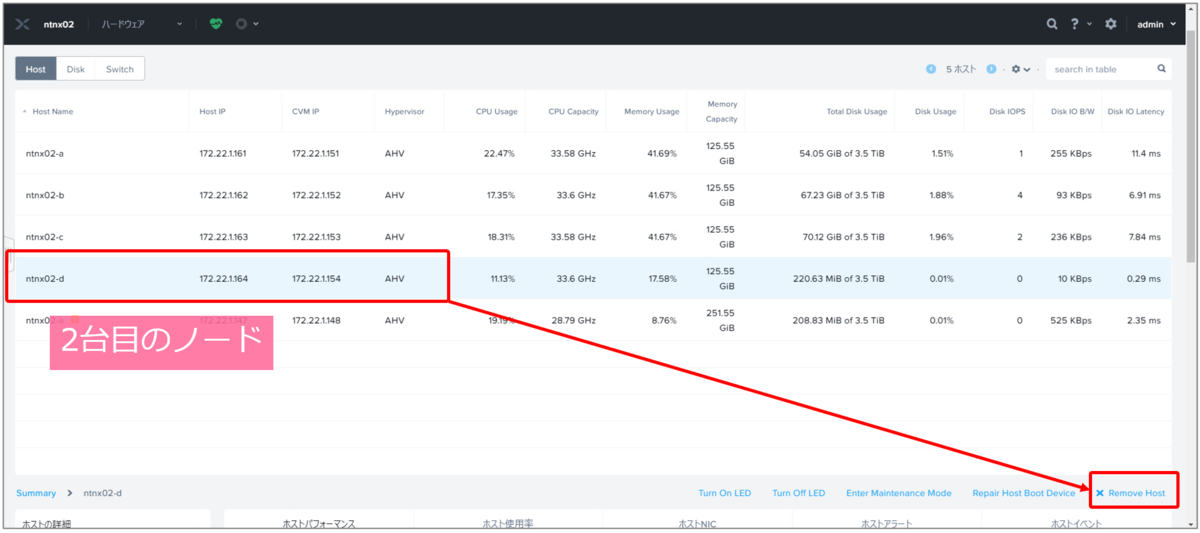

そのまま連続で2台目のノードも選択し「Remove Host」をクリックします。

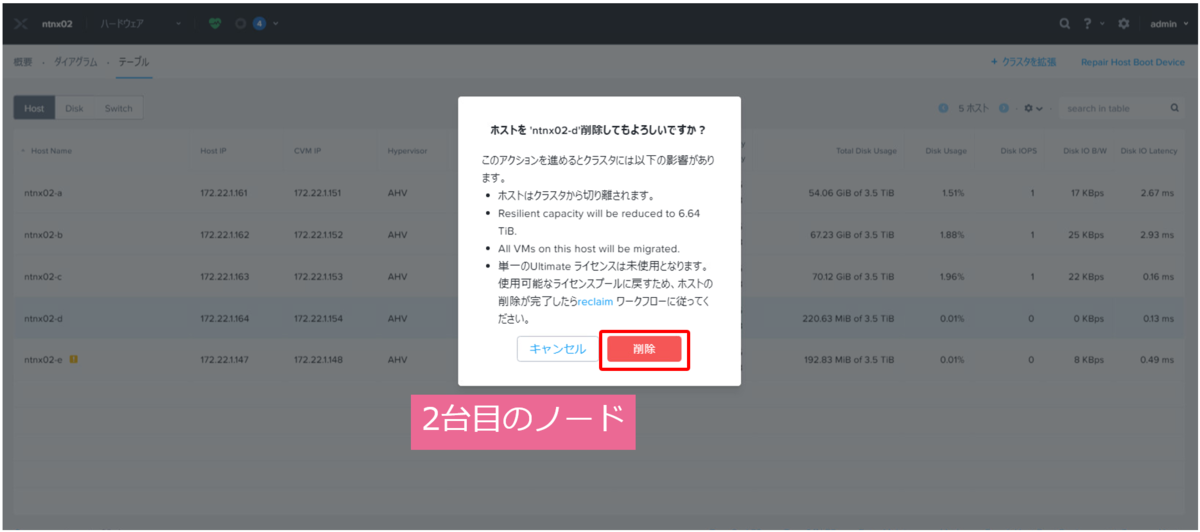

確認のダイアログで「削除」をクリックし、2台目のノードもすぐに削除対象としてマークします。

3. 複数ノード削除中の動き

2つのノードを連続で削除対象としてマークすると、それぞれメンテナンスモードへ移行し、順番にクラスターから削除されます。

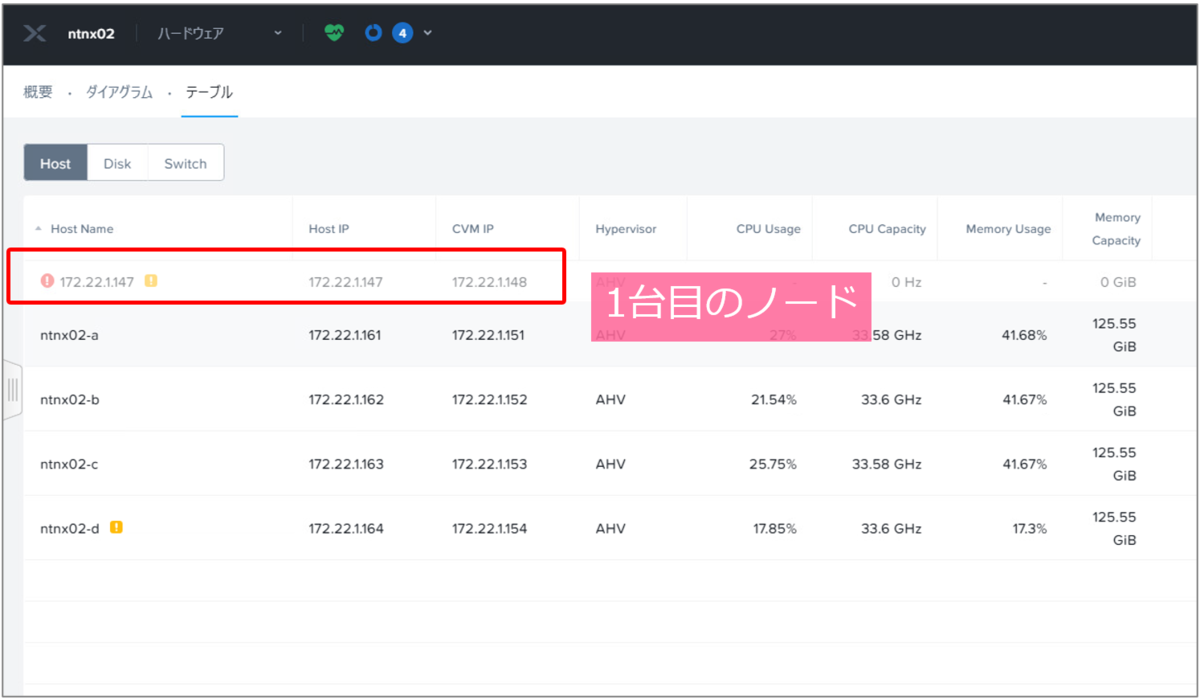

1台目のノードが削除され

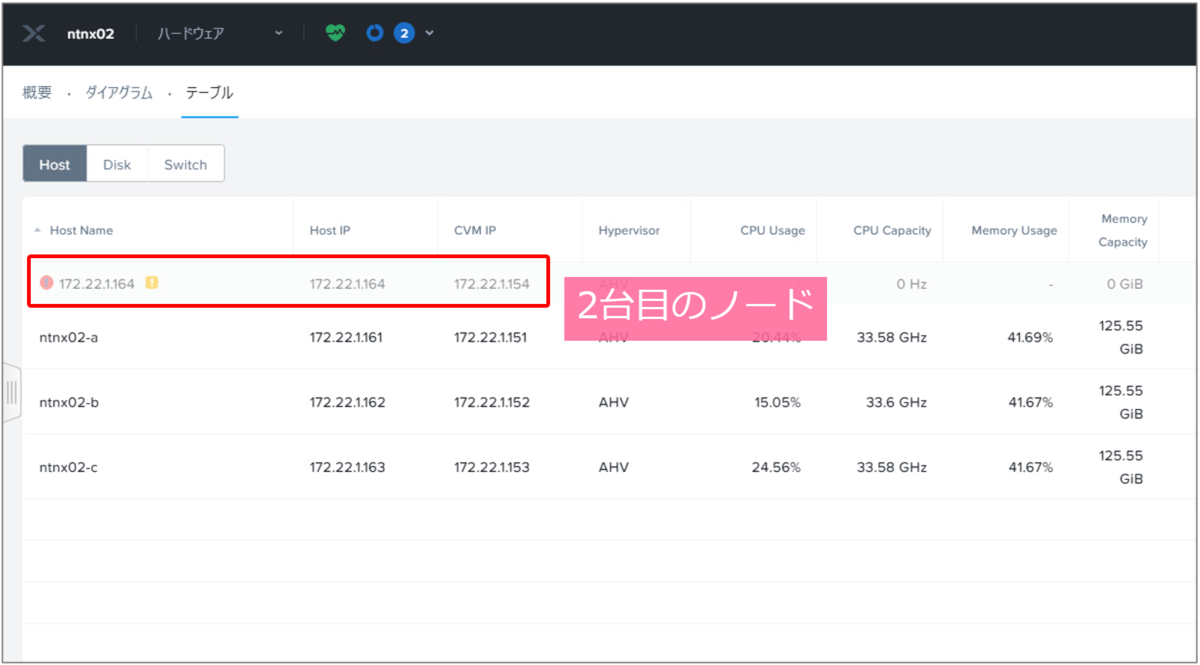

続いて、2台目のノードも削除されます。

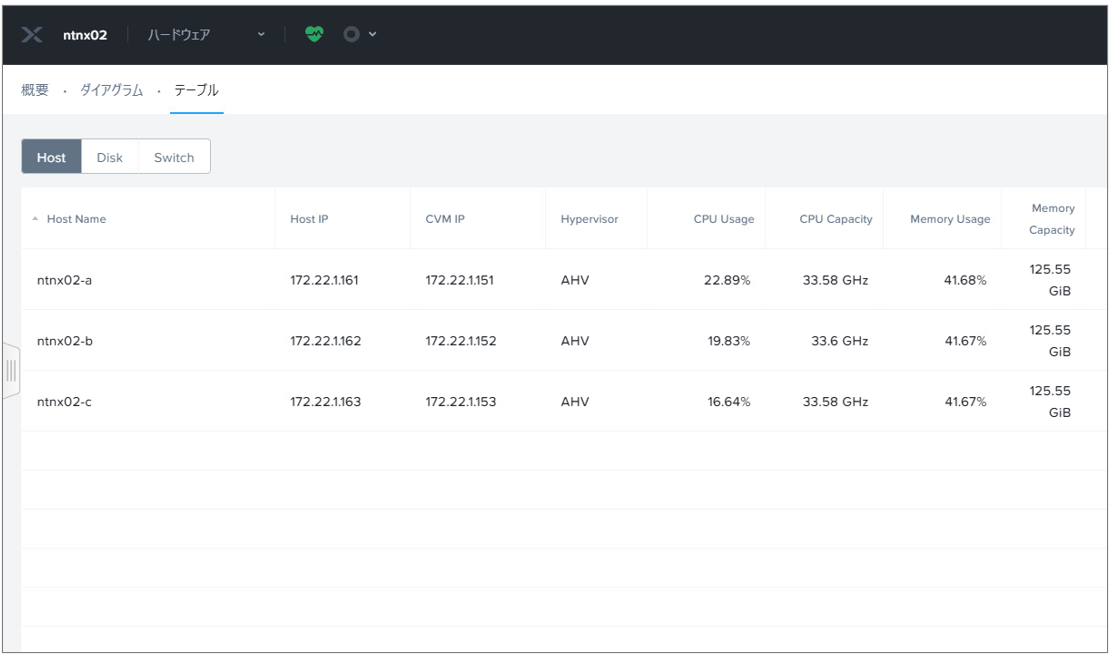

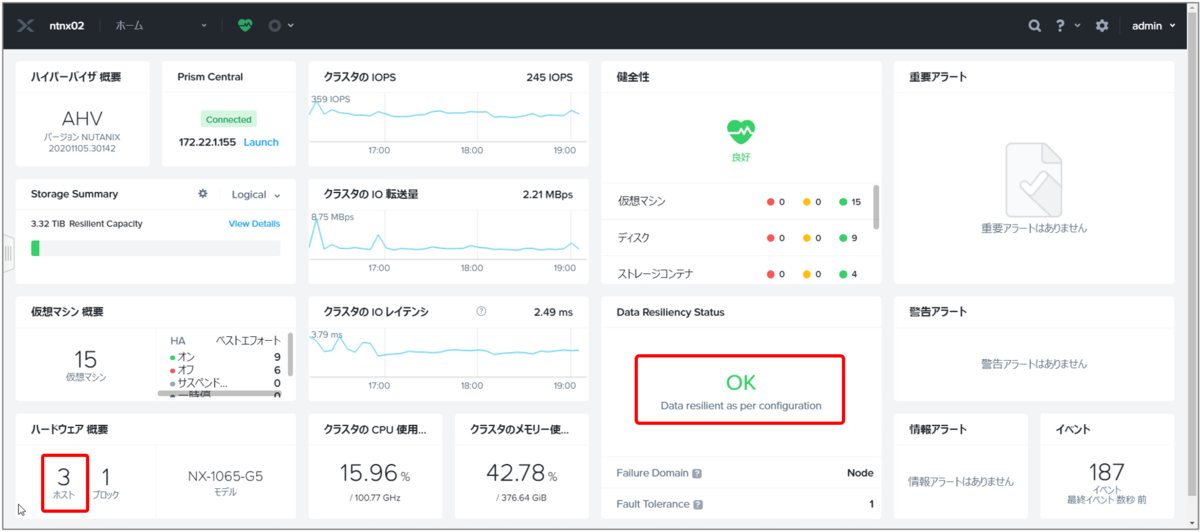

2台のノードの削除が完了しました。

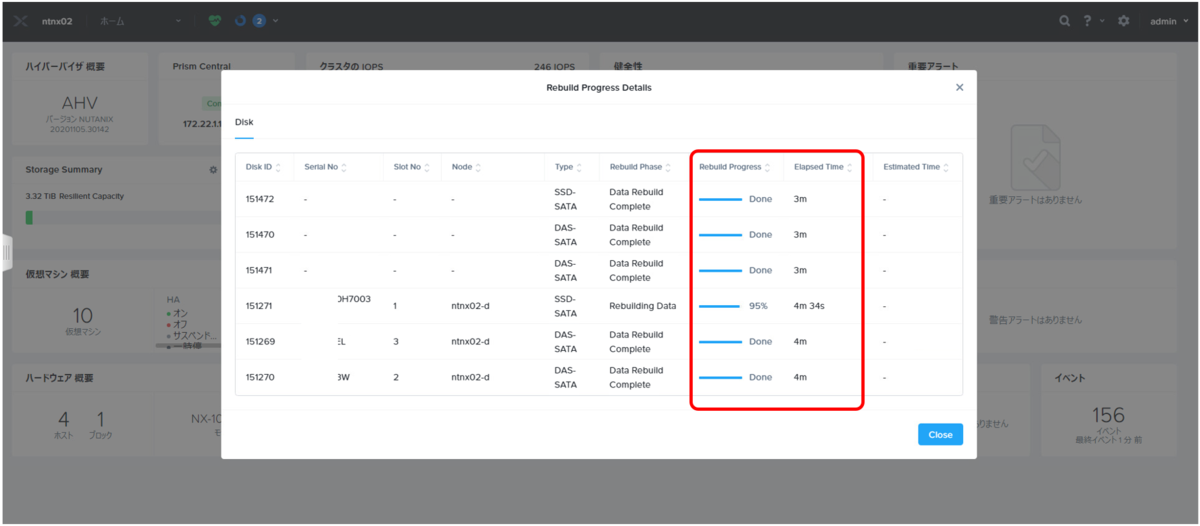

ちなみに削除中は、削除対象ノードのデータがクラスター内の他のノードへコピーされます。Prism Elementの「Data Resiliency Status」から確認可能です。

削除後も「Data Resiliency Status」が「OK」となり、残りの3ノードでAOS Storageが正常に稼働していることが確認できます。

4. 要件や制限事項など

- クラスターから複数ノードを削除しても冗長性が維持できる十分なリソースを確保する必要がある(確保できない場合事前チェックで失敗となる)

- 同時に削除対象としてマークできるのは最大4ノードまで

その他、要件などの詳細は以下ドキュメントをご参照ください。