※この記事は「AOS 7.3 AHV10.3 Prism Central pc.7.3」時点の情報をもとに作成しています。その後の機能アップデートについてはメーカーの公開情報をご確認ください。

今回は、複数のVirtual Switchを持つNutanixのAHVクラスターに新規ノードを追加してみます。Virtual Switch(vs)の設定は、追加後にPrismから実施するパターンで検証します。

目次

1.今回の環境

AOS: 7.3

AHV: 10.3

Prism Central: pc.7.3

HPE ProLiant DX360 Gen10 Plus

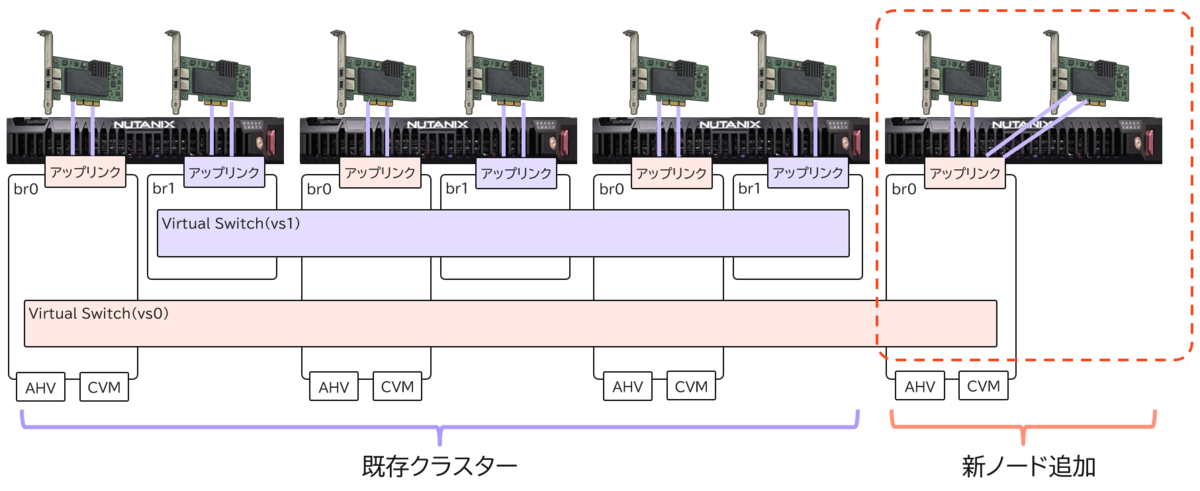

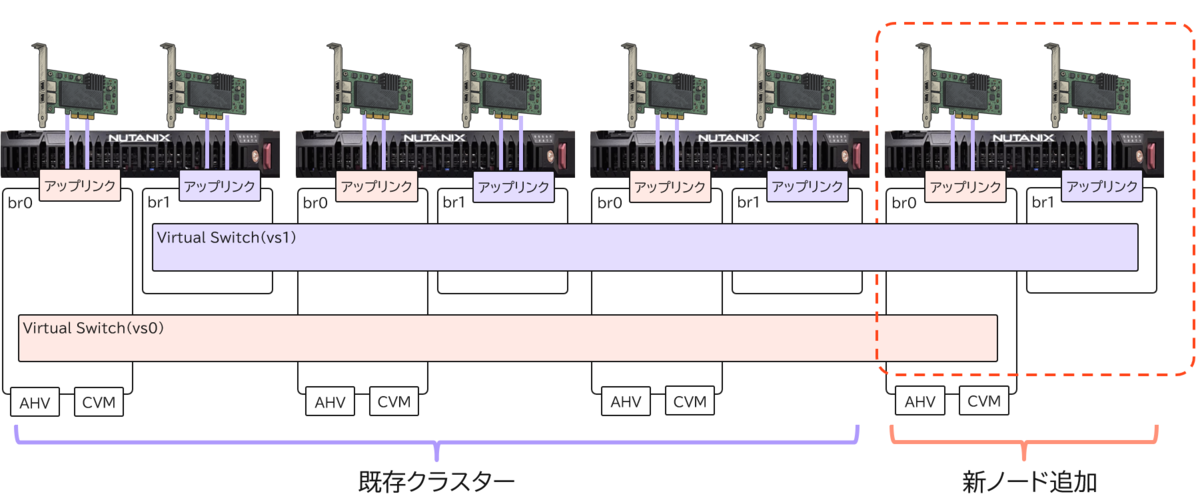

▽今回の環境のイメージは以下の通りです。

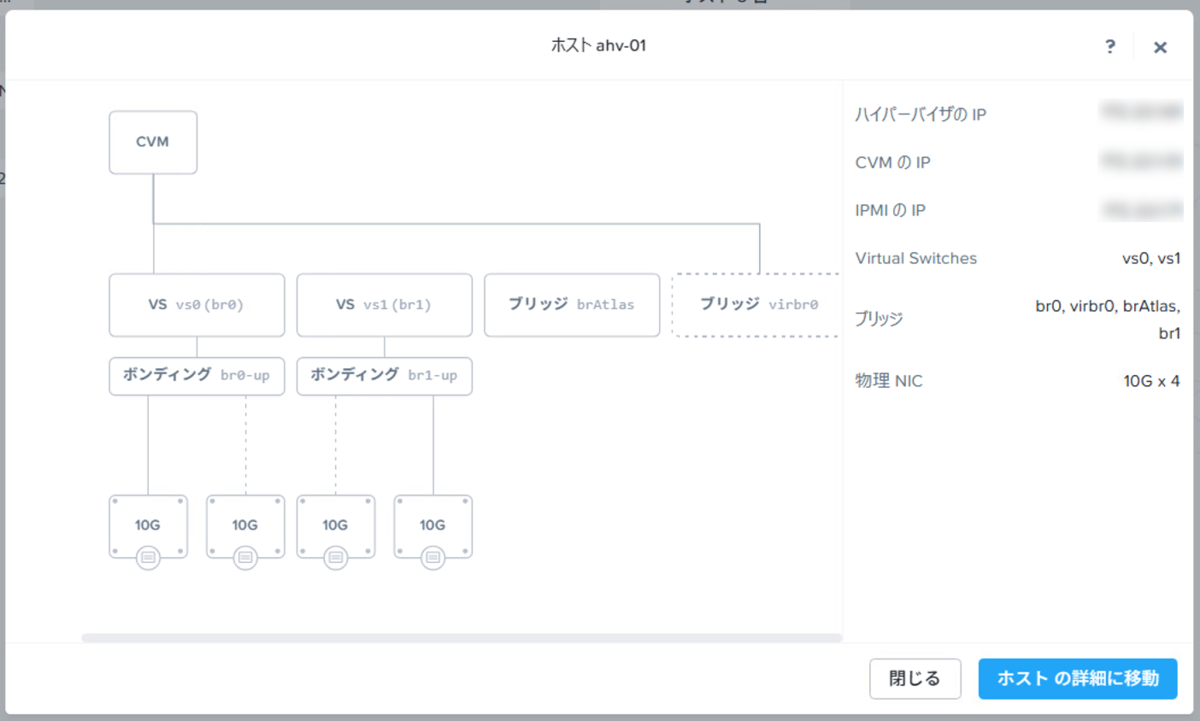

既存クラスターの仮想スイッチの構成は以下の通りです。Virtual Switch(VS)が2つ作成されており、ノードの物理NICのインターフェースに2本ずつ接続しています。

この状態のクラスターに対してノードを追加すると、vs1の分散スイッチには追加してくれるのですが、vs1の分散スイッチにはデフォルトでは追加されない仕様のようです。

そのため、複数のvsを作成してネットワークを分けているような環境では、ノード追加時に仮想スイッチの設定を操作する必要があります。

最近のAOSのバージョンであれば、ノード追加後にPrismで設定変更すれば、自動でvs1への参加やbr1の作成をしてくれますので、今回はこの方法を試してみます。

ちなみに、ノード追加前にあらかじめbr1を作成しておくといった方法もありますが、ノード追加後にvs1には自動で参加してくれないので、結局Prismで設定変更する必要があります。

2. 新規追加ノードの準備

新規ノードを追加する場合は、大きく分けて2つのパターンが考えられます。

- 工場出荷状態の新ノードに対して、既存クラスターのFoundation機能で、ハイパーバイザー・CVMを既存クラスターのバージョンに合わせてインストールし、ノードを追加

- 工場出荷状態の新ノードに対して、事前にFoundationツールを使用して、ハイパーバイザー・CVMを既存クラスターのバージョンに合わせてインストールし、ノードを追加

上の方法は作業としては楽ですが、既存クラスターのリソースを使用してインストールを実施するため、本番環境への影響を軽減したい場合は、下の方法がおすすめです。

Nutanixの追加ノードを購入する際は、販売店や流通業者側で既存クラスターのバージョンに合わせてFoundationを実施してから出荷するサービスがあると思います。

今回は、流通業者側で出荷前にFoundationを実施した状態を再現してみます。Foundationツールを使用して、既存クラスターのバージョンに合わせて追加ノードを準備しました。

準備したノードは以下の通りです。

▽AOSのバージョンが7.3であることが分かります。

nutanix@CVM04~$ cat /etc/nutanix/svm-version

cvm-modern-sts-ganges-7.3-rhel8.10-5.10.234-3.0.1-ganges-7.3-893c9f9-24394-x86_64

▽また、AHVのバージョンもそれに合わせて10.3となっています。

[root@ahv-04 ~]# cat /etc/os-release

NAME="Nutanix AHV"

VERSION="10.3 (enif)"

VERSION_ID="10.3"

VERSION_CODENAME="enif"

ID="ahv"

ID_LIKE="rhel fedora"

PRETTY_NAME="AHV 10.3 (enif)"

▽このノードには2つのNICが搭載されていますが、このすべてである合計4ポートでbr0のアップリンクがチーミングされていることも分かります。つまり、このノードにbr1は存在しません。

nutanix@ CVM04~$ manage_ovs show_uplinks

Bridge: br0

Bond: br0-up

bond_mode: active-backup

interfaces: eth2 eth0 eth1 eth3

lacp: off

lacp-fallback: false

lacp_speed: slow

lacp_status: off

このノードを既存のクラスターに追加してみます。

3. クラスターにノードを追加

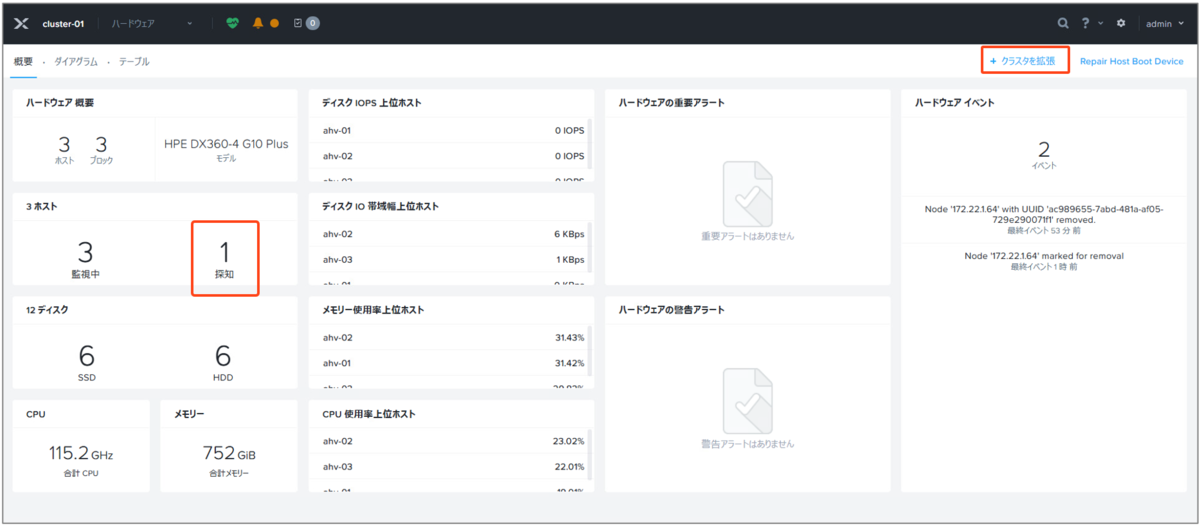

追加ノードを既存クラスター環境に設置し、ケーブル結線してIPv6リンクローカルでディスカバリーできるようにすると、Prism Centralのハードウェア画面で以下のように「探知」に検出された台数が表示されます。

▽これで既存クラスターから追加ノードが見えていますので、「+クラスタを拡張」をクリックします。

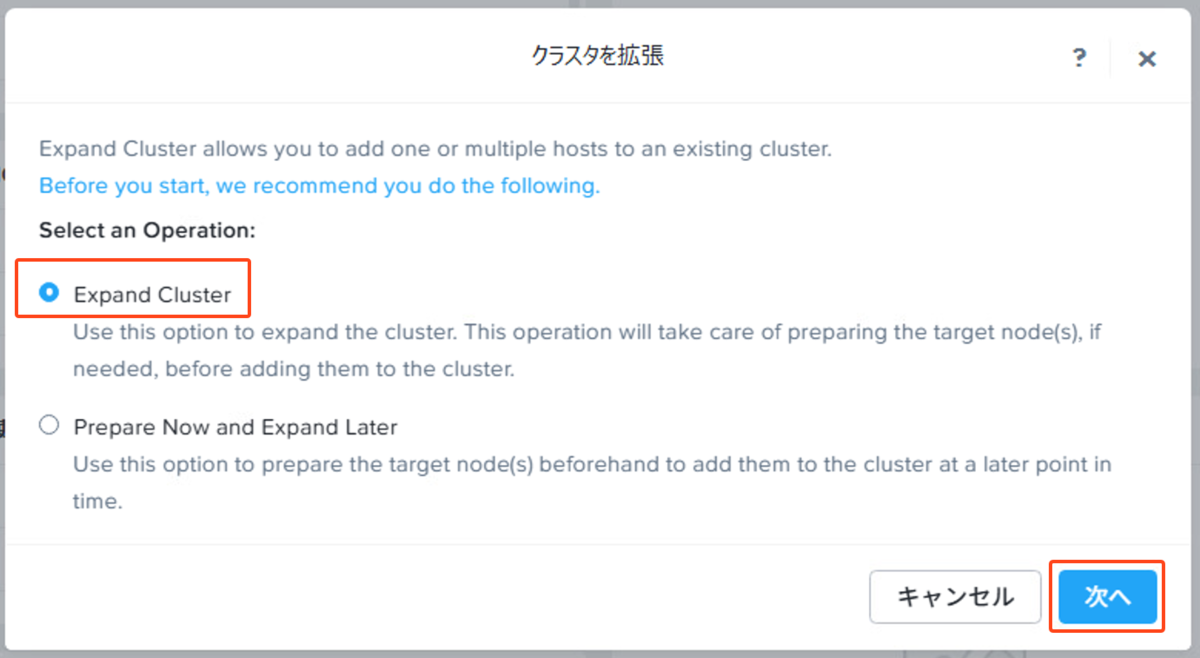

▽Expand Clusterを選択して「次へ」をクリックします。

▽検出されているノードがシリアル番号付きで表示されるので、選択して「次へ」をクリックします。なお、ホストのIPやCVMのIPなども事前のFoundation時の値で表示されます。また、IPv6リンクローカルで検出できない場合は、追加ノードのホストやCVMのIPを直打ちで追加することもできます。

▽ノードタイプは通常の「HCI Node」を選択して「次へ」をクリックします。

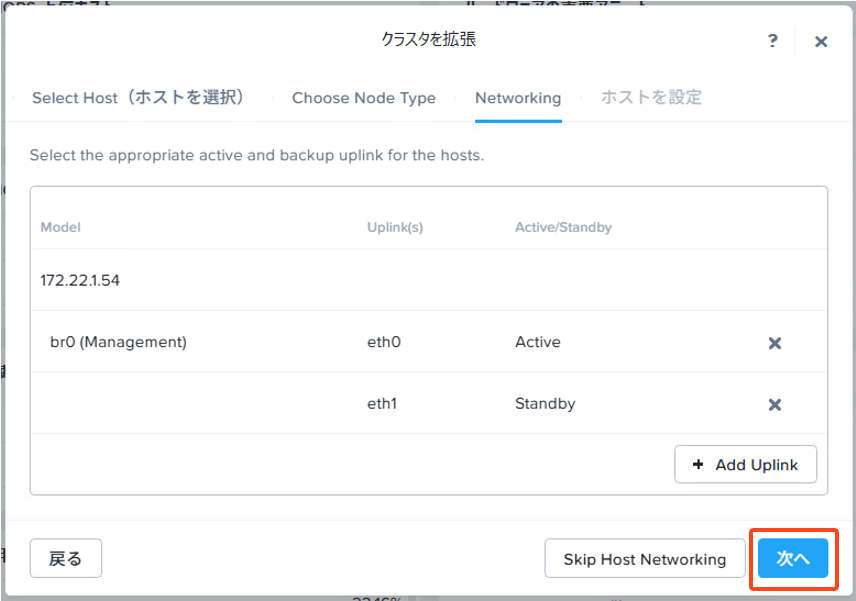

▽Networkingは正直あまりうまく機能しないので、そのままスキップでいいです。図のように2つのポートでアップリンクを設定してみましたが、ノード追加後も結局4ポートのままチーミングされていたりしますので。

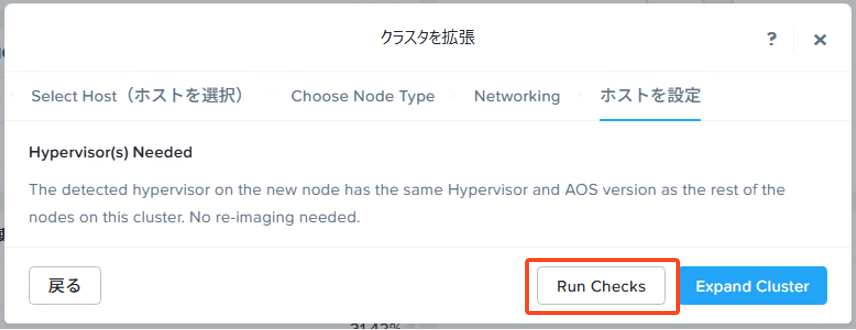

▽今回は既存クラスターのバージョンでイメージング済みなので、そのままノードを追加できます。「Run Checks」で追加前のプリチェックを実施します。

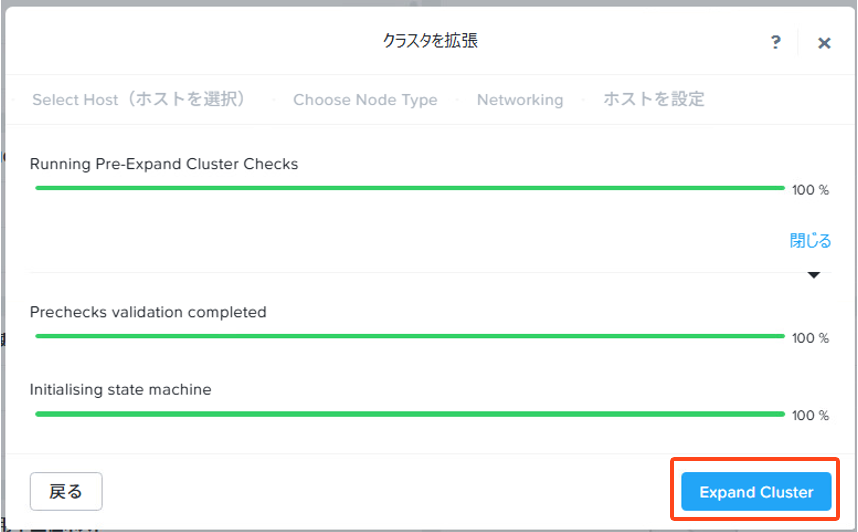

▽プリチェックで問題がなければ「Expand Cluster」でノードの追加を実行します。

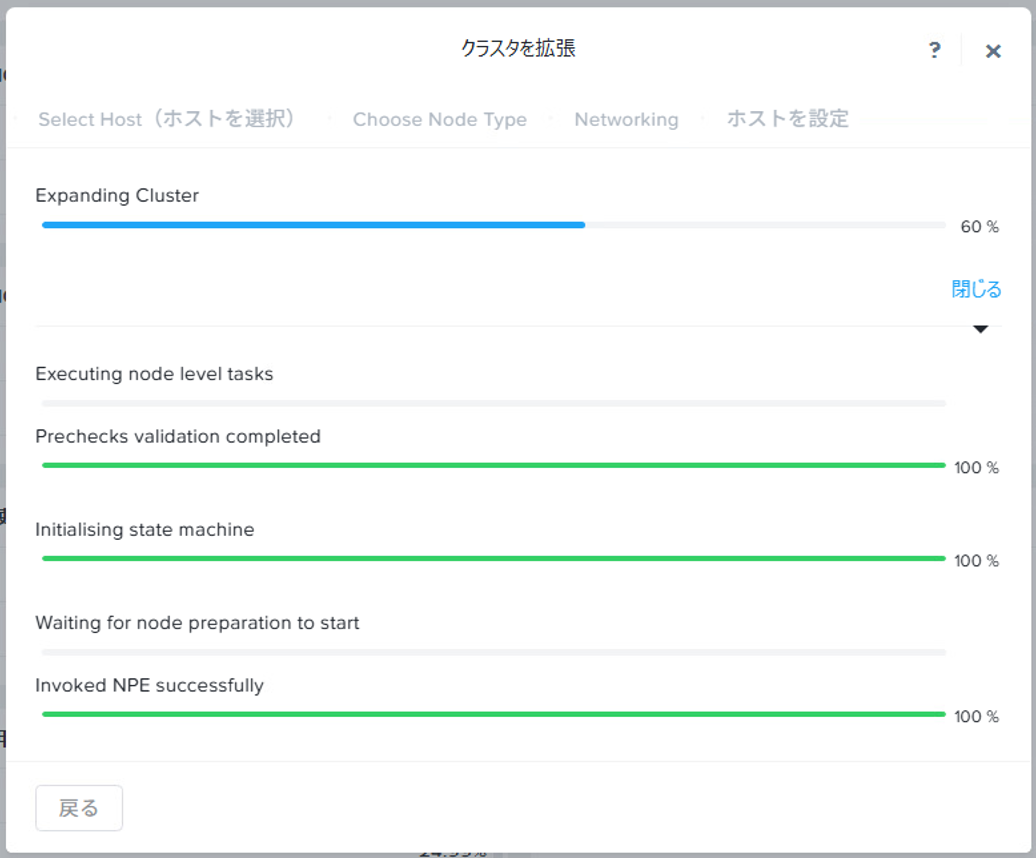

▽ノード追加処理中の画面は以下の通りです。

4. ノード追加後の確認

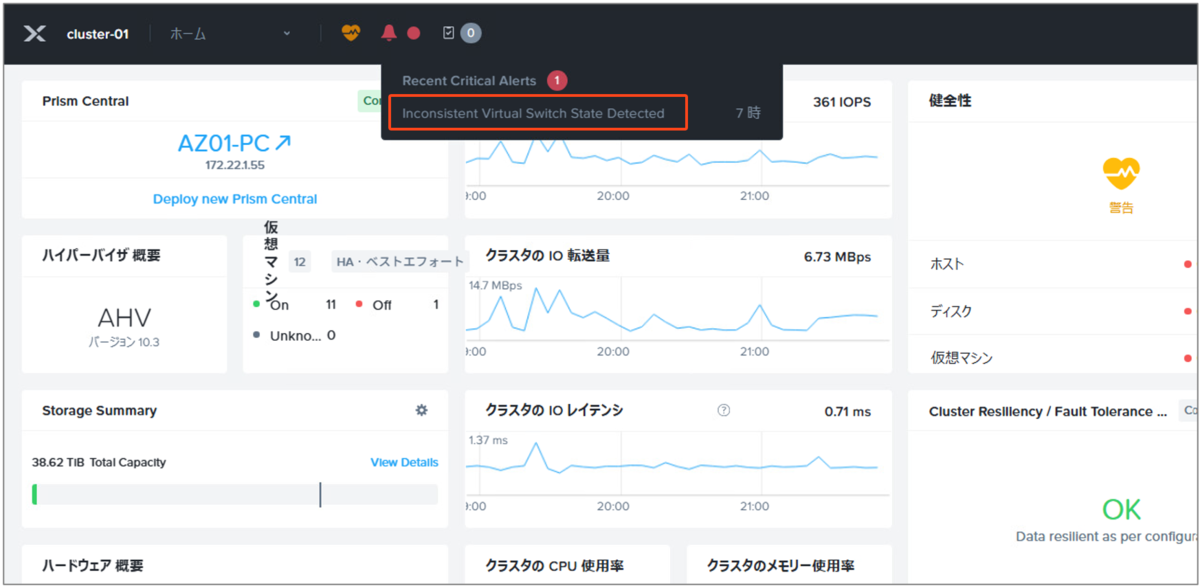

▽ノード追加が完了すると、以下のように仮想スイッチの状態がおかしいといったアラートが出ます。

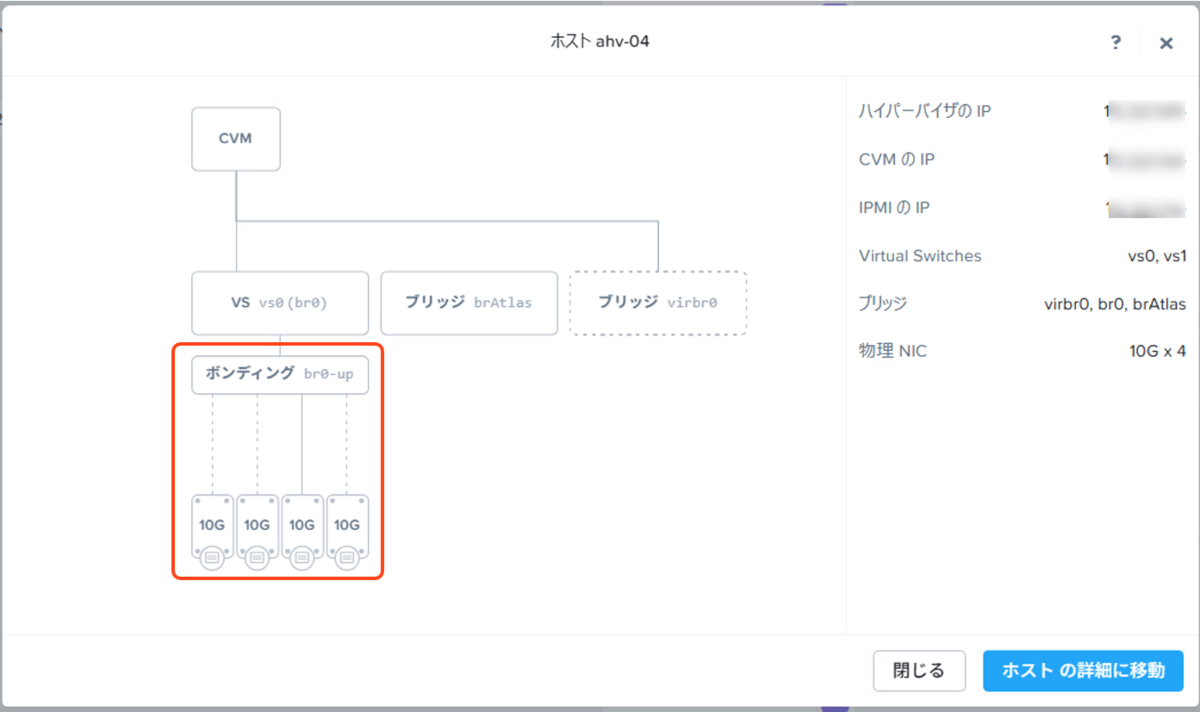

▽追加したノードのネットワーク情報を見てみると、br0にすべてのポートがチーミングされていますね。

▽つまりノードは追加できましたが、以下の状態になっています。

ここからは、仮想スイッチの状態を修正していきます。

5. 仮想スイッチの設定の修正

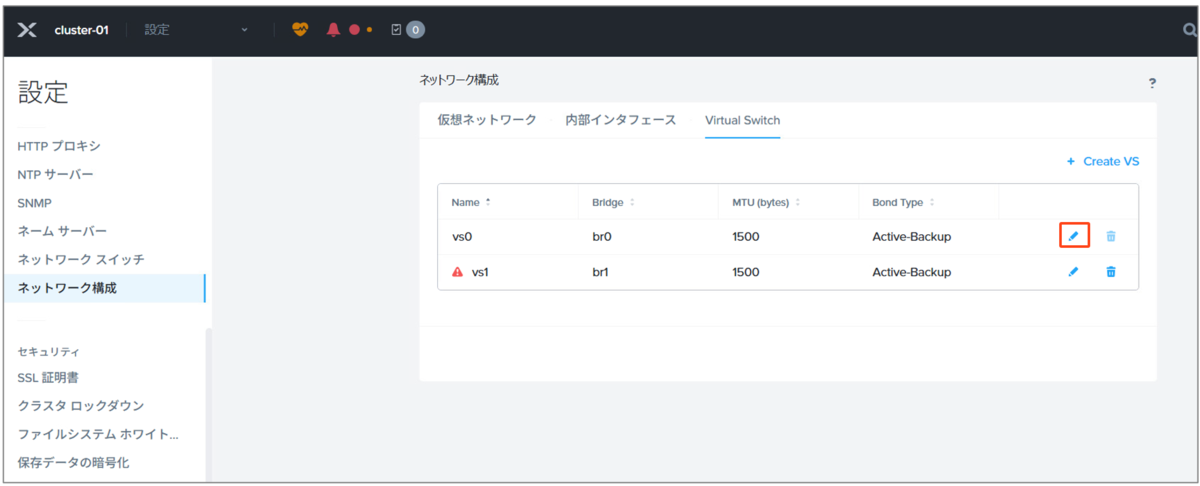

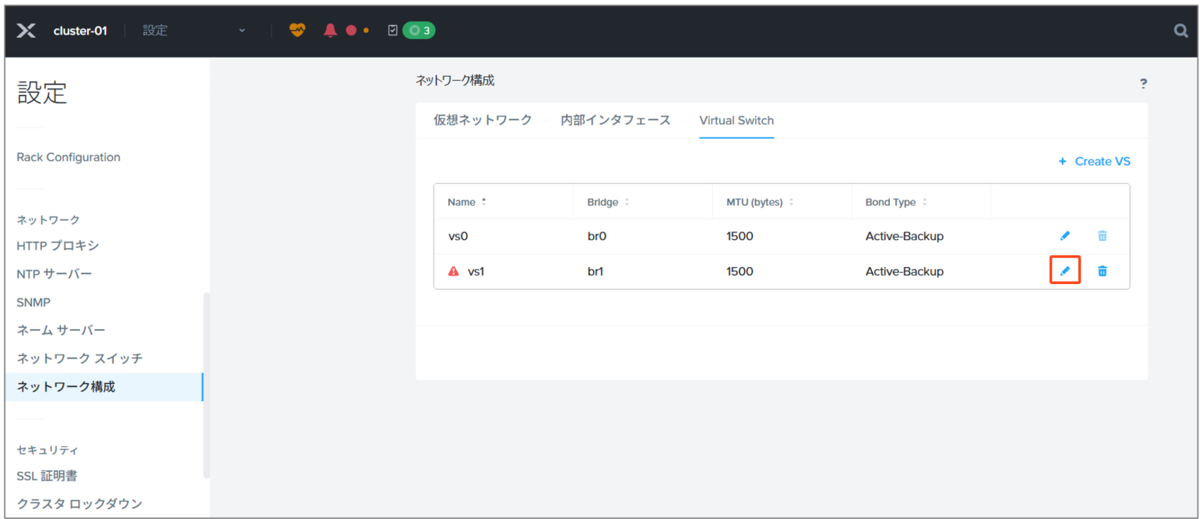

▽Prismにて、ネットワーク構成から「vs0」の編集画面を起動します。

▽そのまま「Next」をクリックします。

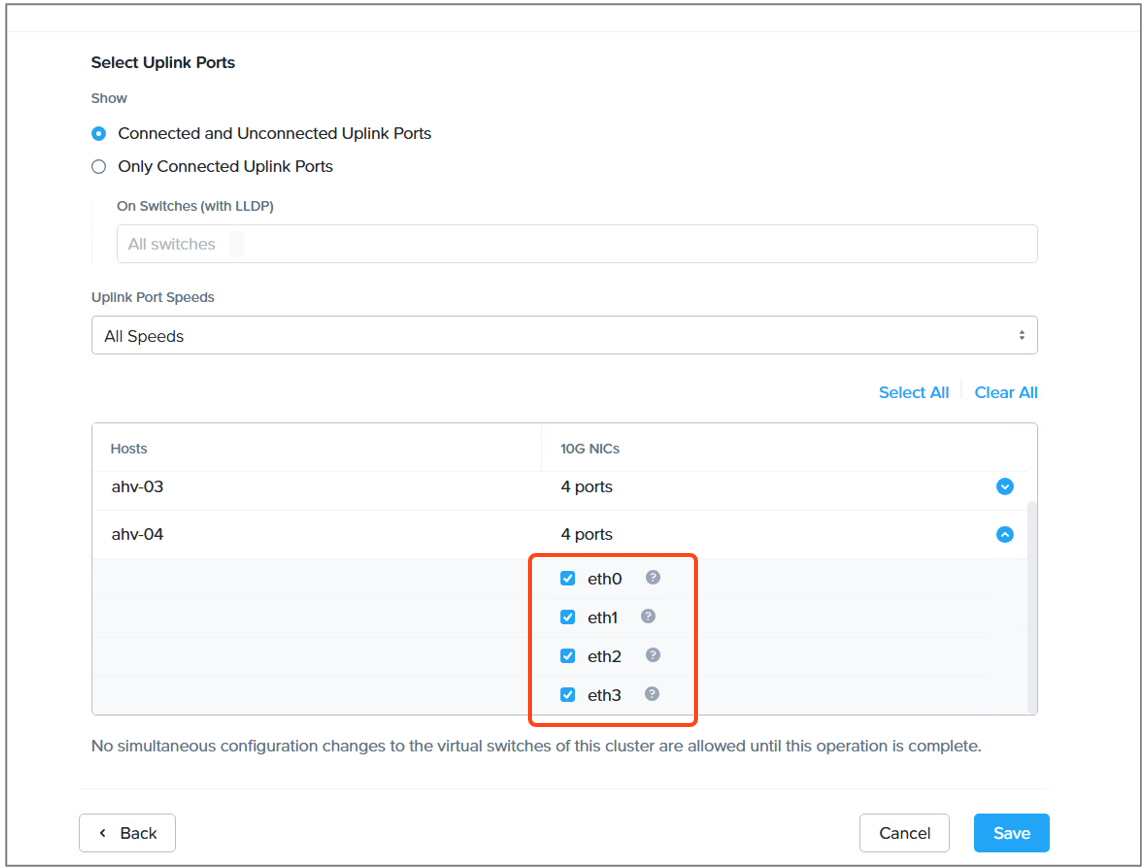

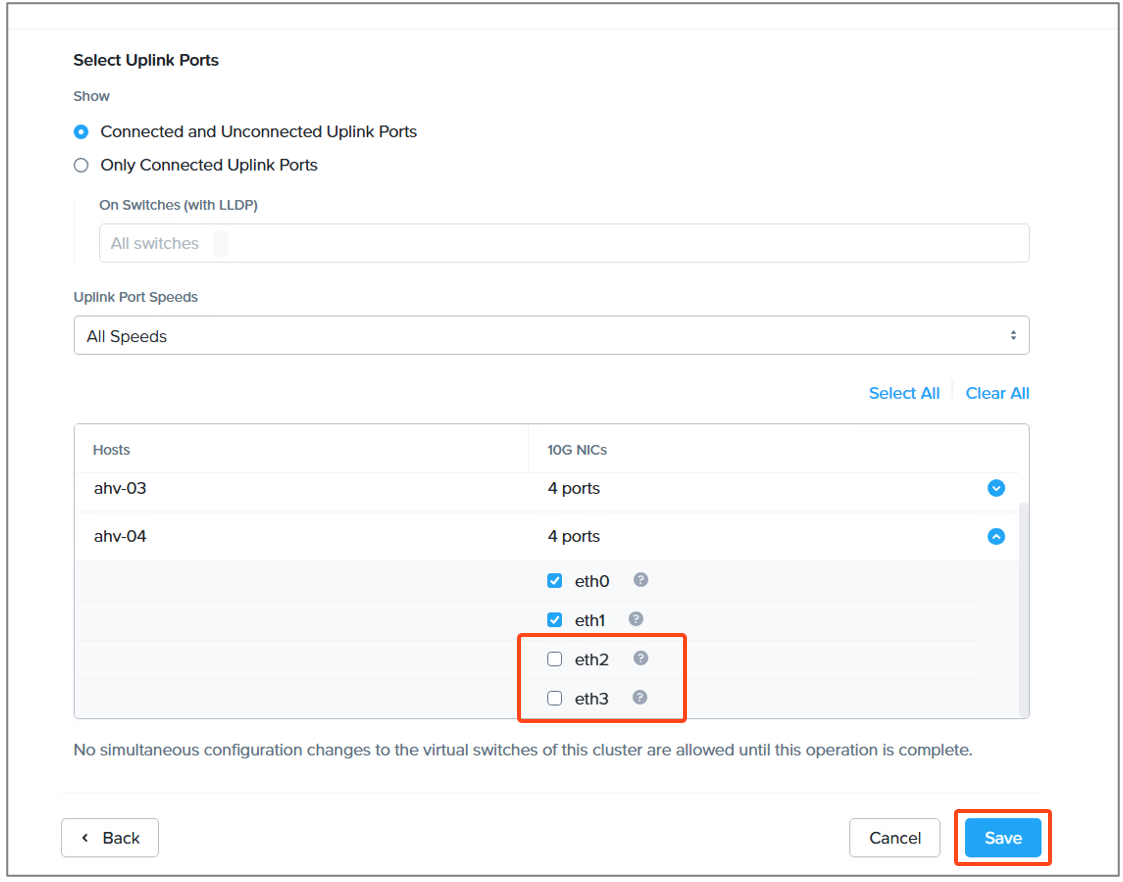

▽追加したノードのアップリンクをポートを確認すると、合計4ポートでチーミングされていました。

▽このうち2つのポートをbr1用に使いますので、2つのチェックを外して「Save」をクリックします。5分程度で処理は完了します。もちろんサービスは無停止です。

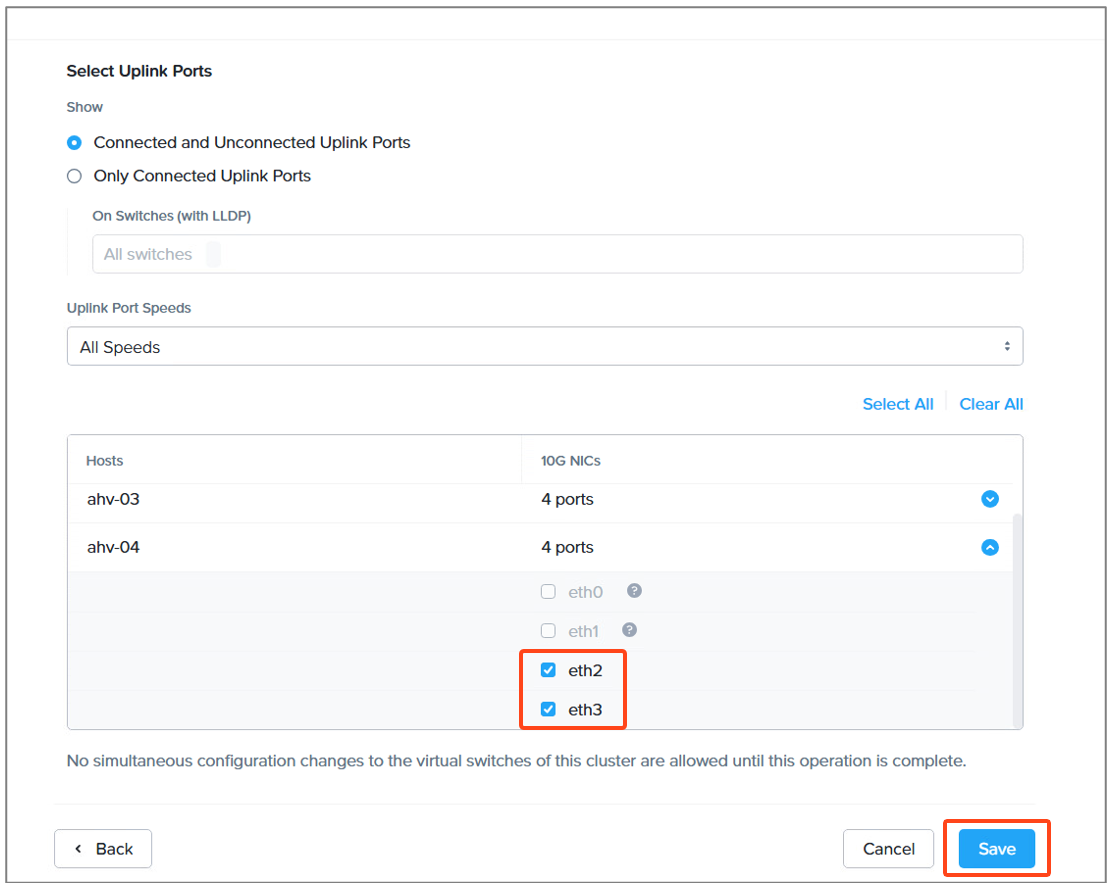

▽処理が完了したら、続いてVS1(br1)の編集画面を起動します。

▽画面を進めて、アップリンクポートの設定で先ほどチェックを外した2つのポートをアップリンクとして選択して「Save」をクリックします。こちらも5分程度で、サービスは無停止での実行になります。

▽これで、以下の状態になりました。

▽追加ノードでコマンドから確認すると、以下のようにbr1も作成されており、アップリンクが2つのポートで設定されていることが分かります。

nutanix@CVM04~$ manage_ovs show_uplinks

Bridge: br0

Bond: br0-up

bond_mode: active-backup

interfaces: eth0 eth1

lacp: off

lacp-fallback: false

lacp_speed: slow

lacp_status: off

Bridge: br1

Bond: br1-up

bond_mode: active-backup

interfaces: eth2 eth3

lacp: off

lacp-fallback: false

lacp_speed: slow

lacp_status: off

これで、仮想スイッチの修正は完了です。

ちなみに、Prism Elementの以下のネットワーク画面は修正後も反映が遅いので、1日くらいたってから確認したほうがいいです。

設定状況の証跡が欲しい場合は、manage_ovs show_uplinksコマンドで確認するのがおすすめです。

今回はここまで。次回は、事前にbr1を作成してみます。